LangChain, qu’est-ce que c’est ?

LangChain est un framework d’IA agentique qui facilite la communication entre vos applications et les grands modèles de langage (LLMs) tels qu’OpenAI, Mistral, Anthropic ou Gemini.

Ces deux apports majeurs sont :

- La possibilité de créer très facilement des agents (plus précisemment des boucles agentiques ReAct)

- Des fonctions standards pour interconnecter tous les outils nécessaires à la création d’applications IA au sein du module langchain-core : API LLM, base de données vectorielles etc.

Les modèles d’IA générative évoluent constamment, utiliser un framework LLM permet aux développeurs informatiques d’utiliser ces modèles sans se perdre dans les détails techniques ou le code spécifique à chaque fournisseur.

Découvrons comment installer LangChain en Python pour créer une toute première application fondée sur l’IA générative.

Configurer LangChain dans l’environnement de développement Google Colab

Google Colab est un environnement de développement Cloud extrêmement pratique pour débuter avec LangChain. Retrouvez nos astuces pour Google Colab ici.

Google Colab est conçu pour l’apprentissage, avec une offre gratuite très généreuse et constitue un excellent point de départ sans les soucis d’une configuration locale.

Commencez par créer un nouveau notebook dans Google Colab, qui vous donne accès à des ressources de calcul gratuites idéales pour l’expérimentation.

Vérifiez que votre environnement fonctionne en exécutant un calcul simple comme 2+2 et ajoutez un titre en Markdown :

# Introduction à LangChainChoisir votre API LLM

LangChain est un framework pour utiliser des IA génératives dans du code Python, mais il ne fournit pas l’IA elle-même.

L’idéal pour démarrer est d’utiliser une offre gratuite, le Google AI Studio est l’un des rare fournisseurs à proposer des appels d’APIs gratuits et suffisants pour débuter.

Open Router propose aussi une petite offre gratuite pour certains modèles. Elle est très limitée mais l’achat de quelques crédits vous permet d’augmenter cette portion gratuite.

Si vous êtes très motivés, vous pouvez aussi auto-héberger un LLM, typiquement avec Ollama.

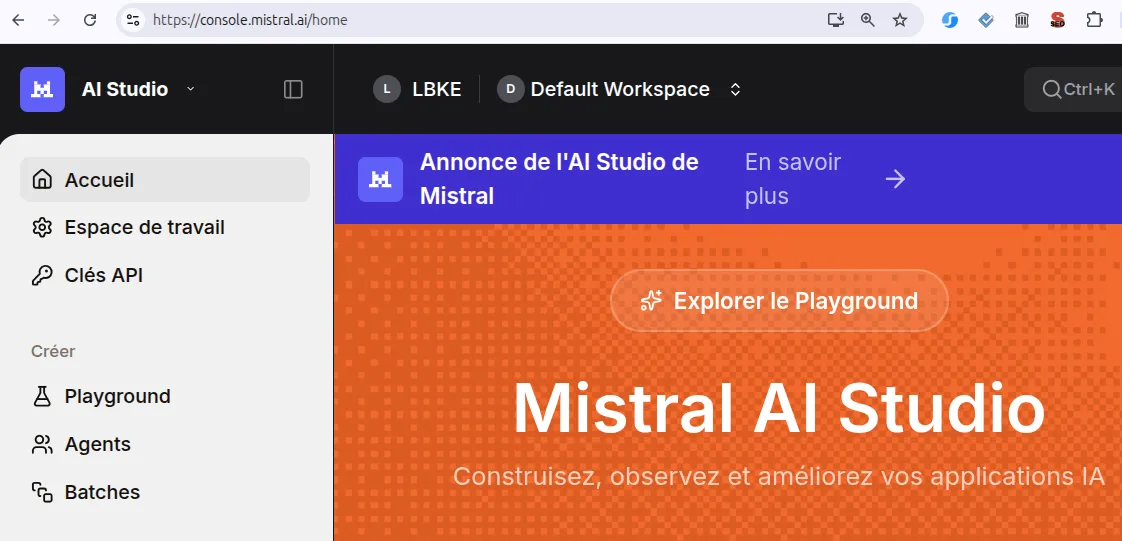

Dans la suite, nous allons utiliser Mistral AI, qui est une API payante mais à l’avantage d’être portée par une entreprise française.

Le Mistral AI Studio permet de créer une clé d’API, utilisable par LangChain pour communiquer avec l’IA générative de Mistral

Le Mistral AI Studio permet de créer une clé d’API, utilisable par LangChain pour communiquer avec l’IA générative de Mistral

À ce stade, vous devez disposer d’une clé d’API, à conserver précieusement, comme un mot de passe.

Installer LangChain et les dépendances spécifiques à Mistral AI

Installez LangChain avec l’intégration de Mistral AI en utilisant cette commande :

%pip install -qU "langchain[mistralai]"La syntaxe %pip est spécifique aux notebooks Jupyter, et Google Colab est justement une version cloud de Jupyter. Elle premet de garantir que la version du package installée est compatible avec l’environnement Python utilisé par Colab (le kernel).

La syntaxe !pip existe aussi, elle est plus générale. Le point d’exclamation permet de lancer n’importe quelle commande Linux.

Gérer les clés API de manière sécurisée

LangChain a besoin de clés API pour communiquer avec les fournisseurs de modèles. Utilisez le module getpass pour saisir votre clé API en toute sécurité :

import getpass, os

if not os.environ.get("MISTRAL_API_KEY"):

os.environ["MISTRAL_API_KEY"] = getpass.getpass("Enter API key for Mistral: ")Un champ va apparaître pour vous laisser copier-coller une clé d’API. Si vous n’avez pas encore de clé d’API, vous pouvez utiliser la console de Mistral AI.

Vous pouvez aussi stocker vos clés dans la gestion des Secrets de Colab, qui est très pratique :

from google.colab import userdata

os.environ["MISTRAL_API_KEY"] = userdata.get('MISTRAL_API_KEY')Cette méthode protège vos identifiants tout en les rendant disponibles pour votre code.

Initialiser la connexion avec le LLM

Après avoir installé LangChain et configuré votre clé API, initialisez la connexion un modèle optimisé pour la génération de code comme Codestral :

from langchain.chat_models import init_chat_model

model = init_chat_model("codestral-latest", model_provider="mistralai")Cela crée une instance de modèle de chat connectée au modèle de Mistral AI spécialisé pour le code. LangChain gère la communication avec l’API, vous permettant de vous concentrer sur votre application.

Votre premier appel à un LLM avec LangChain

LangChain utilise une interface basée sur les messages pour les interactions avec les modèles de chat. On peut passer un seul message au LLM, ou une conversion complète, selon la situation.

from langchain_core.messages import HumanMessage

messages = [

HumanMessage(

"Generate a short Python program with LangChain that sends a message to a LLM."

),

]Il est assez courant d’utiliser un message “system” en plus du message humain, il sert à configurer le comportement du LLM pour toute la conversation. On peut par exemple lui attribuer un rôle : “Tu es un expert de LangChain”.

Envoyer votre premier prompt avec LangChain

Enfin, vous pouvez invoquer le modèle avec votre instruction ou “prompt” et afficher le résult.

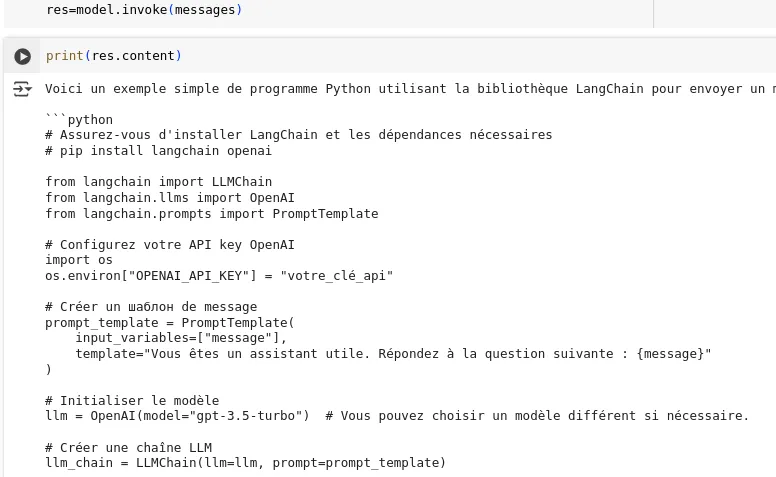

res = model.invoke(messages)

print(res.content)

Le modèle génère du code Python basé sur votre demande. Cela illustre la fonction principale de LangChain : simplifier les appels API en une interface claire et cohérente.

Améliorer la qualité du code généré avec un RAG

Si vous avez observé le code généré par notre appel d’API, vous constaterez qu’il n’est probablement pas à jour.

Cette configuration de base s’appuie uniquement sur les connaissances pré-entraînées du modèle LLM. Installer LangChain n’est que le début, vous allez découvrir toute sa puissance au fil du temps !

Pour aller plus loin, il faudra mettre en place un RAG avec LangChain, c’est-à-dire intégrer automatiquement la documentation à jour au prompt envoyé LLM.

Créer un agent IA avec LangChain

Appeler un LLM avec du code Python vous offre des opportunités infinies ! On parle d’IA agentique pour désigner cette rencontre entre l’IA générative et le code informatique.

La V1 de LangChain, sortie fin octobre 2025, vous permet de créer très facilement des agents. La documentation montre comment créer un agent IA qui donne la météo, capable de se connecter en autonomie à Internet et de parler avec l’utilisateur, comme un chatbot.

# pip install -qU "langchain[anthropic]" to call the model

from langchain.agents import create_agent

def get_weather(city: str) -> str:

"""Get weather for a given city."""

return f"It's always sunny in {city}!"

agent = create_agent(

model="claude-sonnet-4-5-20250929",

tools=[get_weather],

system_prompt="You are a helpful assistant",

)

# Run the agent

agent.invoke(

{"messages": [{"role": "user", "content": "what is the weather in sf"}]}

)Cette boucle agentique est un élément fondamentale de l’IA agentique.

Installer LangChain permet de construire vos applications LLM sur des bases solides

Chaque fournisseur de LLM propose ses propres kits de développement (SDK) et interfaces de programmation (API), chacun avec des exigences particulières.

Sans un framework comme LangChain, vous pourriez devoir réécrire entièrement votre code lors d’un changement de modèle ou vous battre avec des problèmes techniques inintéressants comme la configuration des types de message.

Installer LangChain est le toute première étape pour concevoir des applications d’IA sophistiquées sur des bases solides. Les agents IA proposés par LangChain suffisent à couvrir de très nombreux cas d’usages, leurs limites ne sont pas encore connues.

Pour aller plus loin, LangGraph permet de créer des agents IA et workflows agentiques complexes, au-delà de la boucle agentique ReAct classique.