La plateforme Mistral AI n’est pas une solution satisfaisante pour votre entreprise ou votre usage personnel ? Vous ne voulez pas dépendre d’un acteur tiers non européen comme ChatGPT ? Vous vous êtes peut-être déjà demandé comment être moins dépendant des interfaces commerciales pour l’IA générative.

Voici un guide complet pour auto-héberger sa propre plateforme d’IA générative en entreprise.

Ce guide s’adresse aux aux cadres techniques, DSI, CTO, ou encore aux managers qui doivent gérer un projet de mise en place de l’IA générative en entreprise sans être eux-mêmes techniques, ainsi qu’aux développeurs et DevOps qui devront déployer un LLM en entreprisec .

Dans cet article, on utilisera de façon interchangeable les termes “IA générative” et “LLM”. Le LLM ou “grand modèle de langage” est simplement le cerveau de l’IA, vous pouvez retrouver plus de détails sur le vocabulaire de l’IA dans notre lexique de l’IA générative.

Vous avez déjà mis en place une IA générative en entreprise ? Faites-le savoir en contribuant à l’initiative open source LLM Maison !

Sommaire

Étape préliminaire : bien comprendre le problème de l’auto-hébergement d’une plateforme LLM

- Problème 1 - Héberger le modèle de langage : difficile sur le plan technique

- Problème 2 - Mettre en place une plateforme IA avec interface graphique : une nécessité pour la productivité

Toutes les méthodes pour héberger votre plateforme LLM locale

- 1) Exécuter un LLM sur son propre ordinateur

- 2) Héberger un LLM sur le cloud

- 3) Héberger un LLM sur site en entreprise

- 4) Interfaces graphiques et analyse de documents

Et ensuite, par où commencer ?

Questions courantes concernant l’hébergement local de l’IA

- Les américains peuvent-ils nous espionner si nos données sont sur le cloud ?

- Héberger un LLM localement est-il plus écologique ?

- Doit-on choisir un modèle open source souverain ?

- Mistral est-il un modèle français ou non ?

Étape préliminaire : bien comprendre le problème de l’auto-hébergement d’une plateforme LLM

Avant de parler d’agents autonome, d’AG (intelligence artificielle générale) ou d’automatisation des métiers, il faut d’abord poser des fondations solides. La plateforme LLM est la base de toute stratégie d’intégration de l’IA en entreprise. Prenons le temps de bien comprendre le problème auquel nous nous confrontons.

Une plateforme LLM est constituée deux éléments : une plateforme, et un LLM. Vous auriez pu le deviner ! Mais cette distinction en deux parties est en pratique très importante.

Pour auto-héberger une IA générative, il faut donc résoudre deux problèmes techniques :

- L’hébergement d’une IA générative (LLM, un grand modèle de langage).

- L’hébergement des documents fournis à l’IA, ou générés par elle.

Un projet de mise en place d’une plateforme IA interne à une entreprise se fait donc en deux étapes, héberger la plateforme et héberger le LLM.

Elles se font souvent en parallèle, mais il n’est cependant pas obligatoire de les accomplir en même temps, l’ordre dépendra en pratique de vos contraintes et vos ressources. Par exemple, on peut commencer à mettre en place un RAG en se connectant à l’API cloud Mistral, puis plus tard remplacer l’API par un modèle local.

Problème 1 - Héberger le modèle de langage : le problème difficile de l’inférence LLM

Héberger une IA générative est difficile sur le plan technique, car dans “grand modèle de langage” (la traduction de LLM), il y a “grand”. Si vous n’êtes pas technique, il faut simplement retenir que faire fonctionner un LLM à l’échelle d’une entreprise nécessite une expertise pointue. Si vous êtes techniques, voici quelques pistes pour approfondir vos connaissances sur ce sujet.

Un LLM prend concrètement la forme d’un fichier de plusieurs gigaoctets, dans un format tel que le GGUF qui décrit à la fois l’architecture du modèle et ses poids (concrètement, un très grand ensemble de nombres flottants).

On parle d’inférence pour désigner l’étape de génération d’une réponse à l’aide d’un LLM, à partir du prompt de l’utilisateur. Cette inférence est coûteuse en puissance de calcul et doit donc être réalisée à l’aide d’algorithmes spécialisés implémentés par des framework d’inférence. PyTorch est par exemple un framework générique pour l’apprentissage profond, qui permet d’entraîner et d’exécuter des LLM, et de nombreux outils spécifiques à l’inférence LLM ont émergé ces dernières années : SGLang, TensorRT-LLM, vLLM, llama.cpp…

L’inférence est généralement réalisée sur des cartes graphiques. En effet, l’inférence modèles profonds comme les LLM nécessite des calculs fortement parallisés qui sont assez proches de ceux que l’on retrouve dans le domaine de la 3D et se prêtent bien au modèle de calcul dit SIMT. Récemment, des unités de calculs spécifiques ont été conçus pour répondre aux nouveaux besoins de l’IA : les TPU de Google et les LPU de Groq (dont la propriété intellectuelle a été acquise par Nvidia fin 2025 dans une opération de type “HALO”).

L’inférence sur CPU uniquement est tout de même parfois possible, on la réserve plutôt au déploiement de petits modèles sur machine personnelle, dans une logique “Edge”. Nous allons mentionner dans ce guide de l’auto-hébergement de l’IA des solutions pour faire fonctionner un LLM sur un ordinateur personnel. Cependant il ne faut pas s’attendre à un miracle : seuls quelques modèles spécialement optimisés pour se contexte, et d’une puissance moindre, peuvent être exécutés de cette manière.

C’est pourquoi nous explorerons ensuite des alternatives plus puissantes, adaptées à l’hébergement de l’IA sur site en entreprise.

Pour approfondir le sujet de l’inférence LLM, le LLM Inference Handbook de BentoML est une très bonne ressource en anglais.

Problème 2 - Mettre en place une plateforme IA avec interface graphique : une nécessité pour la productivité

Si vous êtes un développeur informatique, vous pouvez vous contenter de déployer le modèle d’IA : vous obtenez une API LLM utilisable avec un framework comme LangChain ou Vercel AI SDK/Mastra. Mais la plupart des utilisateurs de l’IA générative n’étant pas programmeurs, il faut aussi prévoir une interface graphique associé au LLM.

Ce problème est plutôt fonctionnel que technique, il s’agit généralement d’installer les logiciels adéquats, qui ne sont pas des systèmes d’IA mais bien des interfaces logicielles traditionnelles et qui peuvent être hébergées comme n’importe quel autre service web. *Mais il ne faut pas négliger le rôle de la plateforme LLM dans le succès de l’implémentation de l’IA en entreprise et l’obtention d’un retour sur investissement positif.

L’interface graphique pour accéder aux LLM intègre généralement des fonctionnalités avancés, comme la possibilité d’uploader des documents dans des formats divers.

Ce n’est pas vraiment l’IA qui gère ces aspects, en tout cas pas entièrement : une plateforme telle que ChatGPT, Claude, ou Le Chat de Mistral intègre aussi du code informatique tout à fait traditionnel. Cela permet par exemple d’ingérer les documents et de les préparer avant de les fournir au LLM.

Vous avez peut-être déjà entendu parler du RAG, c’est un exemple de mix entre du code traditionnel, une base de données spécialisée et un LLM.

Sur le plan technique, il s’agit “juste” d’une application web, l’hébergement n’est pas plus complexe que n’importe quel système d’information d’entreprise. Le problème est plutôt de trouver le bon outil et nous allons vous présenter quelques solutions.

Toutes les méthodes pour héberger votre plateforme LLM locale

1) Exécuter un LLM sur son propre ordinateur

Commençons par parler des solutions “ultra-locales”. Il s’agit de faire tourner un grand modèle de langage sur un ordinateur portable ou de bureau classique.

Cela est rendu possible par l’émergence de petits grands modèles de langages - oui ce terme existe bien ! L’abréviation SML pour “small language model” désigne des LLM plus petits, optimisés pour un usage local et pour réduire la consommation de ressources dans l’optique d’une IA plus frugale.

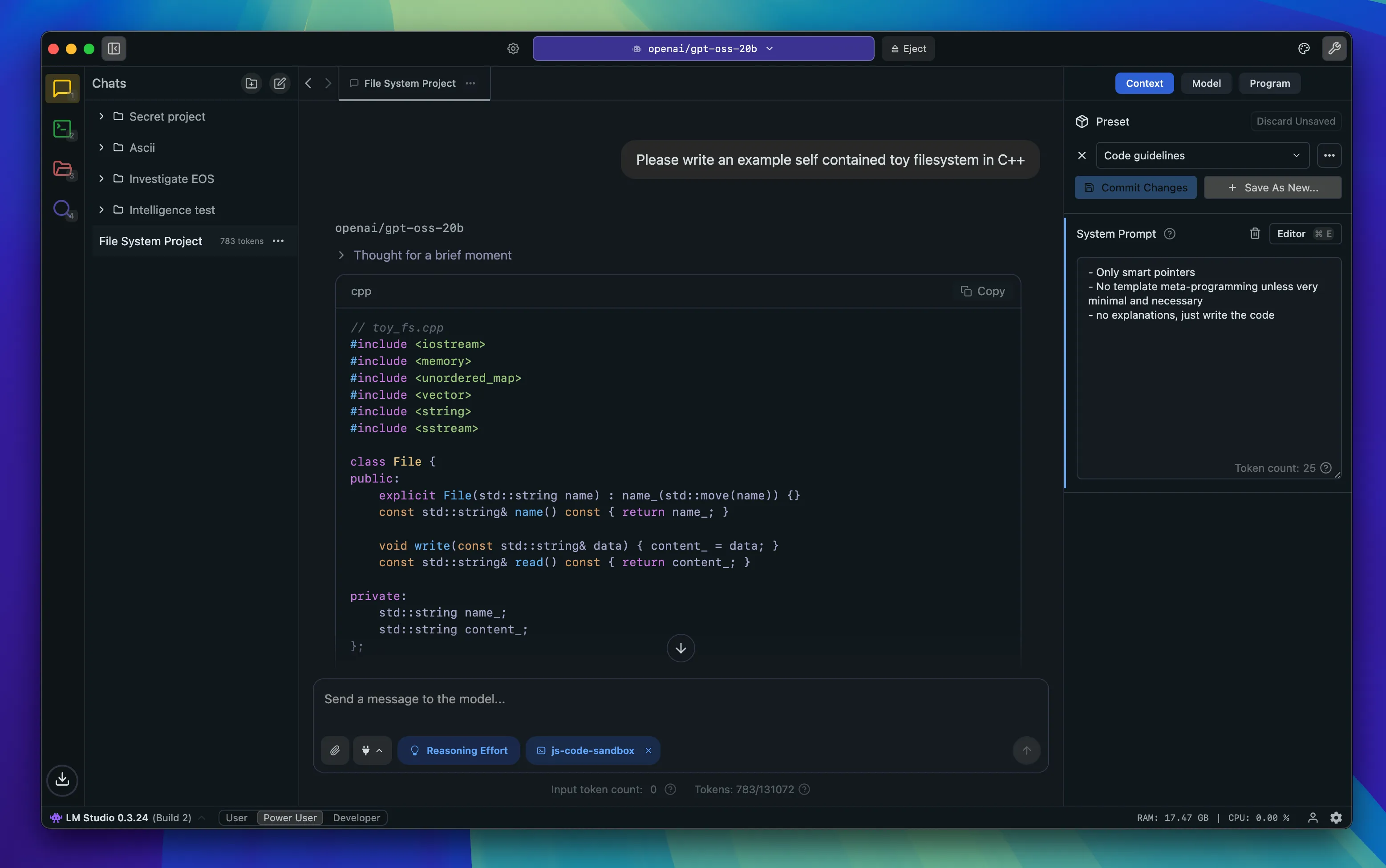

LM Studio est une solution de référence pour l’installation d’une plateforme LLM sur machine personnelle. Le studio vous fournit à la fois la possibilité de télécharger des modèles LLM open source, et de les exécuter au sein d’une plateforme avec interface graphique.

Interface graphique de LM Studio (illustration tirée de la page d’accueil du site)

LM Studio plaira aussi aux développeurs, car la solution peut être connectés à des outils MCP et elle intègre une API qui peut être appelé depuis des programmes informatiques.

Il existe de nombreux concurrents à LM Studio comme GPT4ALL de Nomic AI ou AnythingLLM. Cependant, nous vous préconisons de vous concentrer sur les solutions majeures : les projets open source moins connus sont aussi moins bien maintenus et peuvent donc être vulnérables à des failles de sécurité voire des piratages.

Plus technique, les solutions Ollama et vLLM vous permettent d’exécuter un modèle LLM sous la forme d’une API, donc sans interface graphique. Il faudra coupler ces outils à une interface comme Open WebUI. Le combo Ollama + Open WebUI fonctionne très bien sur machine personnelle, mais a l’avantage de fonctionner aussi en mode client/serveur pour plusieurs utilisateurs dans une petite entreprise.

Pour booster votre installation, vous pouvez envisager l’achat de matériel additionnel. Les constructeurs commencent à concevoir des appareils spécialisés comme le NVidia DGX Spark, qui semble cependant plutôt optimisé pour le fine-tuning d’après le keynote d’introduction (spécialiser des modèles d’IA et non uniquement utiliser des modèles existants)

Enfin, il existe aussi des logiciels et modèles pour des cas d’usage plus précis. Le logiciel open source Vibe vous permet de profiter du modèle de transcription Whisper sur votre machine.

Globalement, faire fonctionner le modèle d’IA directement sur votre ordinateur va fortement brider les résultats que vous pouvez obtenir. Cette configuration est pertinente pour des usages personnels simples ou le traitement de documents hautement confidentiels.

Découvrons des solutions plus avancées, qui conviendrons aux entreprises.

2) Héberger un LLM sur le cloud

Ce guide traite en priorité de l’auto-hébergement de l’IA, cependant, il faut aussi mentionner les solutions intermédiaires. Pour certaines organisations, il est acceptable d’utiliser un LLM hébergé sur le cloud, tant que les documents restent stockés localement sur le long terme.

Si vous voulez maximiser la confidentialité de votre plateforme LLM, vous pouvez déployer votre propre LLM sur le cloud plutôt que de passer par les offres commerciales d’Anthropic, OpenAI ou Mistral.

Scaleway est l’hébergeur incontournable pour l’IA : il s’agit d’une entreprise française avec un centre de données en France. Cocorico ! Surtout, Scaleway offre des hébergements LLM clé-en-main, sous forme d’API (serveur partagé, moins cher) ou en format managé (location d’un serveur, plus cher).

Une autre approche classique est de déployer un modèle sur un cloud traditionnel, dans une zone européenne, via AWS Bedrock, Google Vertex AI et Microsoft Azure AI.

Enfin, la plateforme HuggingFace est la référence pour trouver des modèles open source, elle est l’équivalent IA de la plateforme GitHub pour les développeurs. C’est en pratique sur cette plateforme que les outils comme Ollama vont télécharger les modèles pour les installer sur votre ordinateur. Mais HuggingFace propose aussi de déployer pour vous les modèles proposés par la communauté.

Ensuite, pour l’interface, vous pouvez mobiliser la solution Open WebUI citée plus haut. Cette approche mixte vous évite de stocker vos documents sur un cloud distant, seules les données mobilisées par l’IA sont envoyées sur le cloud.

3) Héberger un LLM sur site en entreprise

Cette troisième approche est clairement la plus technique. Les technologies employées vont être similaires à celles utilisées pour l’hébergement sur un ordinateur personnel.

Mais avec deux difficultés supplémentaires :

- Plusieurs utilisateurs doivent se connecter au modèle d’IA, il faut donc du matériel plus puissant

- Il faut mettre en place une architecture client/serveur, car plusieurs ordinateurs doivent être connecté au même modèle d’IA

- Tous les modèles open source deviennent disponibles : lequel choisir ? Comment ne pas tomber dans le sous-dimensionnement ou le sur-dimensionnement de votre infrastructure IA ?

Cela peut valoir le coup car une telle configuration vous permet d’exécuter des modèles puissants comme les derniers modèles open source d’Open AI, GPT OSS. Le modèle à 120 milliards de paramètres est en effet aussi qualitatif qu’un modèle disponible sur une plateforme SaaS, mais n’est pas conçu pour une exécution sur un ordinateur classique. Les modèles DeepSeek ont aussi la réputation de fournir un bon rapport qualité/coût d’exécution.

Cet article de la société Baseten donne une exemple de configuration viable pour exécuter gpt-oss-120b, avec 4 à 8 GPU. À cette échelle, il devient nécessaire de penser la couche logicielle qui exécute le modèle de manière optimale. C’est pourquoi Ollama a lancé le projet Ollama Turbo, conçu pour mieux exploiter le matériel avancé disponible en entreprise.

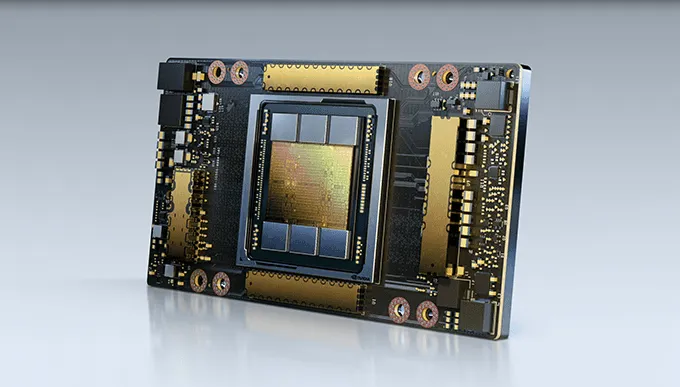

Concernant les cartes graphiques, les solutions souvent citées sont les cartes graphiques Nvidia, notamment les cartes A100 et H100. A ce jour (septembre 2025), une telle carte graphique coûte entre 10 000 et 35 000 euros.

Fort heureusement, il existe aussi des cartes graphiques moins onéreuses, qui peuvent être montées en série sur des chassis. L’ordinateur spécialisé pour le deep learning Tinygrad intègre par exemple plusieurs cartes AMD Radeon ou Nvidia RTX 5090. Attention cependant, toutes les cartes ne se valent pas et ne peuvent pas héberger n’importe quel modèle ! Comme expliqué précédemment, l’inférence LLM est un problème délicat et l’adéquation matériel/modèle d’IA est un sujet technique qui doit être abordé par un expert du domaine.

Une carte NVIDIA A100 avec une unité de calcul spécialisée “TensorCore”. Un tenseur est un objet mathématique important dans le domaine de l’IA, il s’agit d’une forme de vecteur ou matrice généralisée.

Il reste à ce jour difficile d’identifier le meilleur couple modèle/matériel pour un usage données. C’est pourquoi l’Agence LLM a lancé une grande consultation pour documenter les meilleurs installations. Vous pouvez retrouver les premiers résultats sur le site du projet LLM Maison, et même contribuer à l’enquête ! Nous formons chez LBKE les équipes DevOps à l’auto-hébergement de LLM via une formation courte en une journée.

4) Interfaces graphiques et analyse de documents

Une interface graphique pour l’IA ne se limite pas à une banale interface conversationnelle. Les plateformes commerciales majeures ont toutes des fonctionnalités avancées, notamment pour la bureautique, comme la possibilité de fournir des documents pour donner du contexte ou obtenir une analyse.

Plusieurs des solutions mentionnées précédemment gèrent à la fois l’exécution locale du LLM, et l’interface graphique pour l’utiliser, ainsi que des problématiques annexes comme la mise en place du RAG : LM Studio, AnythingLLM, GPT4ALL, Open WebUI…

Prenons l’exemple d’Open WebUI : cette plateforme très extensible est aussi adaptée aux usages avancées de l’IA générative en entreprise. Elle intègre un RAG simple par défaut, et peut être couplée à plusieurs solutions de traitement des documents. La plateforme Open WebUI peut s’interconnecter avec les systèmes techniques conçus par les développeurs IA agentique.

Elle peut même se connecter aux API compatibles avec le format OpenAI (pour Claude et Mistral, un adaptateur est nécessaire), si vous voulez mélanger LLM local et API cloud. Le format OpenAI constituant un standard implicite, tous les outils qui vous permettent d’utiliser OpenAI (modèles GPT) sont aussi généralement compatibles avec OpenRouter, un service cloud extrêmement pratique qui vous permet d’accéder à différents fournisseurs LLM (qui hébergent donc un LLM pour vous) et modèles open source ou privés via une seule et même API.

Contrairement à une plateforme IA commerciale, une plateforme open source vous donne donc une grande flexibilité dans l’intégration de l’IA dans votre entreprise.

On peut faire le parallèle avec le domaine de l’automatisation de processus : nous testons extensivement chez LBKE la version auto-hébergée et open source de n8n pour automatiser nos processus de formation.

Et ensuite, par où commencer ?

Vous savez désormais tout sur l’auto-hébergement d’une plateforme d’IA générative en entreprise. Et ensuite, quoi faire ?

L’enjeu pour réussir la mise en place de votre plateforme LLM est de vérifier que le résultat, c’est-à-dire le mix modèle-matériel-logiciel choisi, convient à vos attentes. Mais vous n’êtes pas obligé d’attendre de brancher votre GPU à 30 000€ pour cela !

Voici le plan de mise en place que l’Agence LLM vous recommande :

- En préalable, constituez un petit jeu de données qui ne pose pas de problèmes de confidentialité. Il sera utile pour comparer des solutions.

- Commencez par mettre en place l’interface graphique. C’est beaucoup plus facile que de déployer une IA ! Par exemple, déployez une instance Open WebUI sur votre ordinateur. Si vous n’êtes pas informaticien, faites-vous aider par un développeur, il n’est pas nécessaire d’être expert en IA pour cela.

- Branchez l’interface avec une API de dernière génération comme Open AI. Testez si les fonctionnalités de l’interface, comme le traitement de documents, vous conviennent dans ce contexte. Observez aussi les coûts pour comparer.

- Testez avec une API qui possède un équivalent open source, par exemple un modèle Mistral. Les modèles disponibles en open source sont listés dans la section “Open” du site de Mistral. Vous pouvez aussi tester un modèles hébergé sur HuggingFace, voir faire un premier essai avec des modèles fonctionnant sur machine locale via Ollama.

- Mettez en place une API sur un cloud français avec serveur mutualisé, ou éventuellement sur un serveur dédié si vous avez le budget. Il faut compter de quelques centaines à quelques milliers d’euros, cependant un essai d’un mois vous coûtera toujours moins cher qu’une carte graphie dédiée à 10 000€.

- Enfin, si vous avez passez toutes les étapes précédentes avec succès, et que vous êtes certains de vouloir passer sur un hébergement local, vous pouvez passer à l’achat du matériel spécifique.

Bien sûr, vous savez peut-être déjà exactement ce que vous voulez. Vous pouvez notamment vous inspirer d’entreprises partenaires qui ont des besoins similaires aux vôtres et leur demander des informations sur leur configuration.

Tous les feedbacks sont bons à prendre et l’entraide est un facteur important pour le succès de votre projet d’auto-hébergement d’une plateforme LLM !

Merci d’avoir parcouru ce guide. Nous le mettons à jour régulièrement en nous appuyant sur nos échanges avec les professionnels de l’hébergement. Si vous souhaitez y contribuer, contactez-nous par mail.

Pour allez plus loin dans la maîtrise de l’IA au sein de votre entreprise, découvrez notre nouvelle formation à l’auto-hébergement d’un LLM en entreprise par Nicolas Karageuzian, et l’offre de service de L’Agence LLM par LBKE, qui accompagne les entreprises dans leurs projets de mise en oeuvre de l’IA générative.

Remerciements à : Ovea, Nudibranches et aux membres des réseaux Digital 113, Montpellier Tech Hub et La Boucle qui ont répondus à nos questions sur l’hébergement d’IA.

Questions courantes concernant l’hébergement local de l’IA

Pour compléter ce guide, voici des réponses aux questions courantes qui sont régulièrement posées par les participants à nos formations.

Les américains peuvent-ils nous espionner si nos données sont sur le cloud ?

Le Cloud Act permet à la justice américaine de demander l’accès aux données de citoyens ou résidents des États-Unis. Cette page d’Amazon décrit en détail le principe du Cloud Act.

Le problème pour nous européens est que Cloud Act est une loi extra-territoriale : il s’applique aussi aux données stockées en dehors des Etats-Unis, tant qu’elles concernent un citoyen ou résident américain.

On peut l’envisager comme une mesure de rétorsion contre la RGPD, qui est aussi un loi extra-territoriale car elle s’applique aux entreprises ciblant le marché Européen, y compris lorsqu’elles sont installées en dehors du territoire de l’Union.

Ces demandes d’accès ne sont pas pour autant dérégulées, elles doivent s’appuyer sur des décisions de justice. Utiliser un hébergeur américain n’est pas devenu soudainement un problème catastrophique et reste une décision technique raisonnable.

L’hébergement local doit donc généralement être motivé par d’autres raisons qu’une réaction au Cloud Act :

- Volonté de privilégier des acteurs locaux et européens

- Haut niveau de confidentialité et volonté d’éviter tout risque associé à une potentielle mise en application du Cloud Act, même avec un risque minime

- Motifs contractuels imposés par un client

- Recherche d’alternatives plus écologiques

- Etc.

Héberger un LLM localement est-il plus écologique ?

Nous ne disposons encore que de peu de données concernant l’impact écologique des IA générative (en 2025), cependant on sait déjà qu’ils s’agit d’intelligences artificielles particulièrement consommatrices de ressources.

Pour la simple et bonne raison qu’un LLM est un “grand modèle de langage” : c’est sa taille, en nombre de “neurones”, qui fait sa puissance. Une IA générative est forcément coûteuse à entraîner et faire fonctionner.

On peut saluer ici les résultats publiés par Mistral suite à une étude réalisée avec l’Ademe et Carbone 4, qui donnent quelques chiffres parlants : une page de texte générée par un modèle Mistral Large correspond à 10 secondes de streaming. La comparaison est bien choisie car le streaming est connu pour être aussi consommateur de ressources. Un article récent du journal Bon Pote s’efforce de quantifier plus précisémment l’impact environnemental global de l’IA.

On peut émettre dès aujourd’hui quelques hypothèses raisonnables :

- Utiliser des modèles plus petits consomme moins de ressources et d’énergie.

- Mutualiser les calculs réduit la consommation de ressources et d’énergie.

- L’impact environnemental dépend beaucoup du contexte : choix techniques de l’hébergeur, mix énergétique dans le pays où est installé le data center.

Faire chauffer son mac dernière génération toute la journée, ou acheter son propre GPU d’entreprise et le sous-utiliser, est selon ces hypothèses moins efficace que de passer par un hébergement cloud mutualisé en France par exemple.

Doit-on choisir un modèle open source souverain ?

Les modèles open source sont explicitement identifiés dans le America’s AI Action Plan de juillet 2025 comme des outils d’influence internationale pour les États-Unis, au sein d’une stratégie qui implique aussi une forte dérégulation et l’exclusion des notions de désinformation, diversité, équité, inclusion et changement climatique dans le référentiel d’évaluation des risques NIST.

La dimension open source n’implique donc pas nécessairement une valeur éthique supérieure.

L’intérêt de l’open source réside plutôt dans la possibilité d’héberger le modèle sur une infrastructure contrôlée, et aussi de pouvoir diversifier la provenance des modèles employés.

Cependant, en termes de possibilité de fuites de données, l’auto-hébergement résout en théorie ce problème, même pour un modèle conçu hors union européenne.

C’est en effet la librairie open source générique, par exemple Ollama ou vLLM, qui va mobiliser des technologies bas niveau comme PyTorch pour exécuter le modèle open source. Le modèle LLM téléchargé depuis une plateforme comme HuggingFace ne réalise pas de calculs à proprement parler. Le LLM se limite à décrire une architecture de calcul et les paramètres du réseaux de neurones profond, via le format GGUF.

C’est donc la technologie d’exécution qui doit être auditée pour la sécurité, et non le modèle LLM open source. À ce jour, il n’existe cependant pas encore de standard public permettant de valider le niveau de sécurité et de confidentialité de l’exécution locale d’un modèle d’IA open source pour un couple technologie d’exécution/modèle donné.

Mistral est-il un modèle français ou non ?

Mistral, notre champion français des LLM, propose des modèles open source et des modèles privés. La question de sa dimension “souveraine” est souvent débattue à la machine à café. En tout cas si vous prenez le café à la même heure que les DSI !

Si vous hébergez vous-même ou via un cloud français un modèle open source, la question de la souveraineté est moins importante. Le LLM n’est in fine qu’un très grand paquet de chiffres et l’utilisation d’un modèle qui n’est pas produit en Europe n’est pas nécessairement problématique, en tout cas au regard de la confidentialité des données. Les modèles de la société chinoise DeepSeek ont par exemple une bonne réputation pour l’auto-hébergement du fait de leur rapport intelligence/taille avantageux.

Pour les modèles accessibles via la plateforme Mistral, non open source, le mieux pour obtenir des réponses à vos questions est d’analyser la politique de confidentialité. Elle s’avère très bien rédigée et lisible par l’humain, sans même la faire résumer par un LLM. Mistral annonce privilégier des prestataires européens, sauf cas exceptionnels, et dans tous les cas conformes à la RGPD.

Un hébergement “Enterprise”, c’est-à-dire sur des serveurs qui vous sont dédiés, est aussi envisageable mais si la possibilité d’accéder à cette offre pour les PME semble inconnue. Le siège social de Mistral est situé en France, l’entreprise est donc considérée comme française.