Vous venez d’installer Cursor, par exemple pour vibe coder votre prochaine application web ou dans le cadre de notre formation Cursor pour devenir développeur augmenté.

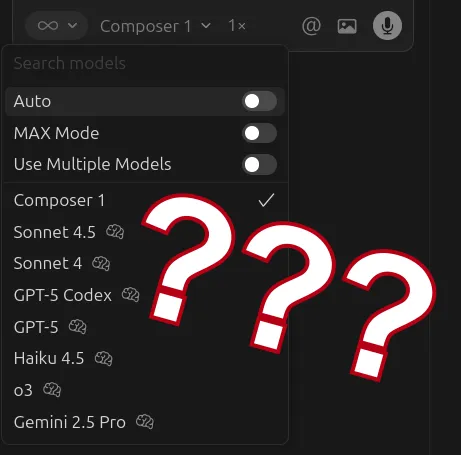

Vous découvrez l’interface, et tombez par accident sur ce menu déroulant, qui vous paraîtra totalement obscur si vous ne suivez pas l’actualité des LLM en temps réel.

On en est déjà au 5ème GPT, vraiment?

On en est déjà au 5ème GPT, vraiment?

Découvrons ensemble les méthodes possibles pour bien configurer votre modèle LLM dans Cursor.

Les trois critères de choix : prix, qualité, vitesse

Le prix est le premier critère à prendre en compte : l’IA générative coûte cher en puissance de calcul, se qui se retranscrit sur votre porte-monnaie !

Les plateformes d’IA pour le grand public fonctionnent par abonnement. Mais les API, qui sont utilisées par des outils comme Cursor, adoptent plutôt une facturation à l’usage.

Plus précisément, la facturation d’une API LLM se fait en fonction des tokens d’entrée et des tokens de sortie (les tokens de sortie étant plus chers).

Depuis juillet 2025, Cursor adopte une facturation hybride, avec un abonnement de base, et la possibilité de payer à l’usage ou de passer à un abonnement supérieur si vous consommez beaucoup de requêtes vers des modèles de frontières, c’est-à-dire les meilleures IA disponibles.

Tableau des prix pour les modèles les plus courants (octobre 2025). Les montants sont décomptés de votre abonnement, et vous commencez à payer à l’usage si tout l’abonnement est consommé.

Tableau des prix pour les modèles les plus courants (octobre 2025). Les montants sont décomptés de votre abonnement, et vous commencez à payer à l’usage si tout l’abonnement est consommé.

La qualité du résultat est ensuite bien sûr un aspect important. Le plus souvent, on va d’abord tester un modèle simple (moins cher) avant de passer sur un modèle plus avancé en cas d’échec.

Enfin, la vitesse est aussi un point qui peut changer la vie au quotidien. Lorsque l’on apprend à devenir développeur augmenté, on apprécie la capacité de Cursor à coder automatiquement pour nous. Mais on se lasse aussi très rapidement d’attendre 10 minutes en regardant au plafond le temps d’obtenir une fonctionnalité !

Découvrons quatre approches pour choisir le modèle idéal avec Cursor.

Méthode 1 : laissez faire Cursor avec le mode Auto

Le mode Auto de Cursor n’est pas une simple option de configuration de l’assistant de code IA : Auto est un véritable modèle d’intelligence artificielle qui analyse les requêtes pour choisir le meilleur LLM !

On appelle cela le routing, ce pattern est très courant en IA agentique pour optimiser les coûts. Les IA génératives peuvent en effet différencier une demande complexe qui nécessite une IA avancée, et une demande plus simple pour laquelle il faut préférer un modèle peu coûteux.

En terme de facturation, les requêtes Auto sont à un tarif nettement inférieur à l’utilisation d’un modèle que vous auriez choisi explicitement.

Le mode Auto un excellent choix par défaut, surtout si vous restez sur l’offre la plus basique de Cursor.

Méthode 2 : choisir toujours le meilleur modèle

Quand vous voyez une mouche, vous ne pouvez pas vous empêcher de sortir le bazooka ? Vous pouvez être tenté de choisir un modèle de raisonnement avancé comme Claude Opus 4.1.

Cependant, vous allez vous confronter à plusieurs problèmes :

- un modèle plus intelligent est souvent plus lent, car il procède à une étape de raisonnement

- un modèle plus intelligent est aussi plus cher

- en fait, on ne sait même pas si les modèles de raisonnement raisonnent vraiment, comme Apple l’a évoqué dans son article “The Illusion of thinking”

Vous l’aurez compris, on vous recommande plutôt de prendre le temps de découvrir les caractéristiques de chaque modèle pour faire un choix éclairé selon votre problème.

Méthode 3 : choisir le modèle d’IA à la main pour certaines tâches

Un modèle comme Claude Opus 4.1 sera à privilégier pour les tâches nécessitant un raisonnement complexe, par exemple la planification des étapes pour l’initialisation des projets.

Les modèles Gemini 2.5 Pro et GPT 4.1 tolèrent quant à eux un très grand contexte d’un million de tokens (contre 250 000 d’habitude), pour charger des fichiers ou des instructions très longues.

Si vous préférez la vitesse, GPT-5 Fast vous donnera une réponse deux fois plus vite… pour deux fois plus cher !

Il faut aussi mentionner une actualité très récente : Cursor a introduit dans sa v2 son propre modèle d’IA, Composer, devenant ainsi un fournisseur de modèle LLM et non plus uniquement un éditeur de texte. Composer met l’accent sur la rapidité pour être compétitif avec des modèles établis comme les modèles Claude d’Anthropic.

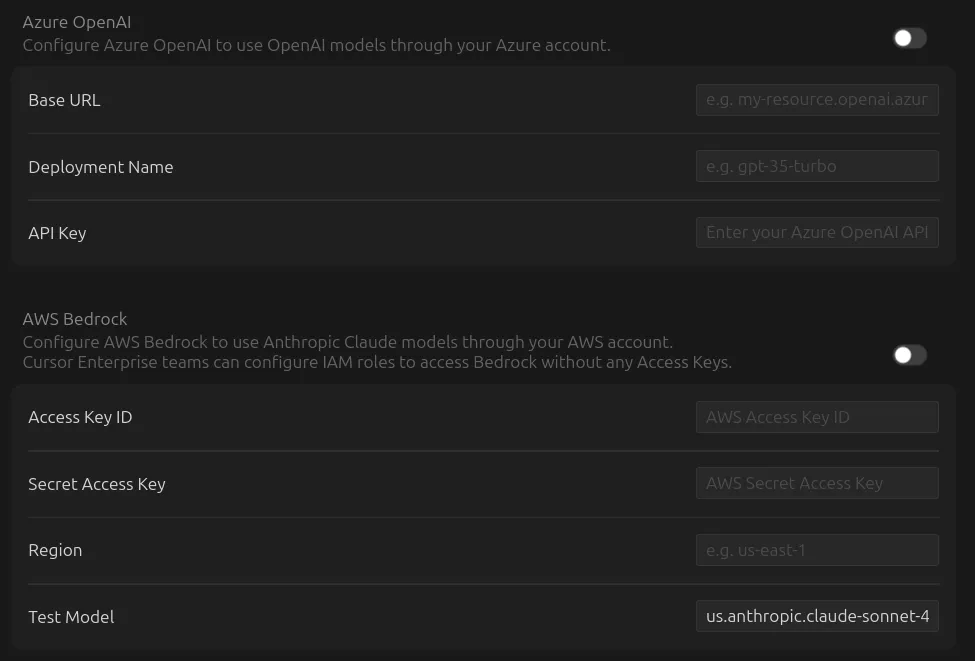

Méthode 4 : amener vos clés (BYOK, bring your own key)

Les entreprises hébergent parfois leur LLM privé sur le cloud. Cursor vous permet de configurer vos propres URL et clés API, notamment pour les hébergeurs Azure et AWS Bedrock.

Cependant, si vous voulez opter pour un modèle LLM auto-hébergé, il faudra plutôt aller voir du côté de l’éditeur de texte open source void.

Conclusion : laissez faire l’IA… ou pas !

Personnellement, je m’en tiens en pratique systématiquement à la méthode 1, laisser faire Auto. Mon utilisation de Cursor est assez classique : gérer le site de LBKE, créer des applications SaaS ou encore des supports de cours interactifs.

Néanmoins, les puristes et les développeurs qui utilisent Cursor à longueur de journée apprécieront beaucoup la possibilité de configurer le modèle LLM utilisé pour traiter leurs requêtes.